Larrabee: Toekomstmuziek? Intel heeft zich jarenlang niet gemengd in de grafische strijd tussen ATi en Nvidia. Intel hield zich bezig met CPU's, de andere twee met grafische chips (GPU's). Sinds kort echter is hier verandering in gekomen. Misschien mede door het feit dat AMD en ATi verenigd zijn?!?

Larrabee: Toekomstmuziek? Intel heeft zich jarenlang niet gemengd in de grafische strijd tussen ATi en Nvidia. Intel hield zich bezig met CPU's, de andere twee met grafische chips (GPU's). Sinds kort echter is hier verandering in gekomen. Misschien mede door het feit dat AMD en ATi verenigd zijn?!?Intel heeft dan ook de laatste maanden redelijk veel details vrijgegeven van wat hun eerste antwoord zal zijn.

Tegenwoordig ziet het er nog als volgt uit:

- Nvidia richt zich op de 'general purpose-code' van de grafische chip. Daarmee willen ze zeggen dat de rekenkracht die door een GPU gegenereerd kan worden, voor alles moet kunnen dienen én snel en eenvoudig moet kunnen aangesproken worden. Daardoor zal de rol van een 'gewone' CPU in 3D-applicaties een belangeloze rol krijgen.

- AMD ziet het véél breder. Hen maakt het niet uit of de code uiteindelijk op een CPU dan wél een GPU terechtkomt. Door de overname van ATi hebben ze beide soorten chips in huis. En zoals iedereen weet, gaat het AMD de laatste tijd niet voor de wind op gebied van de CPU's, waardoor men zich daar meer op de GPU's gaat focussen.

- Intel dan, heeft zich tot nu toe prima gericht op de CPU, en dan meerbepaald de multicores. Grafisch bleven ze beperkt tot hier en daar een onboard chip, niks om naar huis te schrijven.

Als we spreken over rekenkracht, spreken we over 'flops'. En om je een idee te geven; een topmodel CPU als de 'Nehalem' moet in het stof bijten voor een GPU als de HD4870 of de GTX280 en dit met een factor 10 !

En die rekenkracht in de realiteit aanspreken, blijkt nog een graad moeilijker. En zeker voor 'gewone' programma's. Men moet al echt goed op de hoogte zijn van de interne werking van de GPU om software te laten draaien op een GPU. Maar technologie en ontwikkeling staan natuurlijk niet stil, waardoor de kloof steeds kleiner wordt en hardware steeds flexibeler. Maar zolang we daar niet zijn kan software voor een CPU niet verplaatst worden naar een GPU en vice versa.

Daarom ook dat Intel besloten heeft op de kar te springen. En dit met de Larrabee... een ver schaalbare multicorechip die dienst kan doen als GPU. En niet als energiezuinige oplossing maar ook voor de die-hard gamer ! !

De Larrabee wordt gebaseerd op een 'gewone' x86-core waardoor die door DirtectX en OpenGL aanspreekbaar zal zijn. Op zich is dit een groot voordeel ten opzichte van de concurrenten.

De Larrabee is een hele kleine simpele core. In de ontwerpfase heeft men berekend dat binnen het transistorbudget en het tdp van een Core 2 Duo maar liefst 10 Larrabee-cores passen, die tezamen dus 40x zoveel floating point-werk per kloktik kunnen verzetten.

De heel concrete details zijn nog niet bekendgemaakt, maar al snel wordt duidelijk dat er mogelijk 8 tot 64 cores in een Larrabeechip kunnen zitten. Het aantal zal dan afhankelijk worden van de doelgroep waarvoor hij bestemd is, al is hier nog niks concreets over bekend.

Even de technische kant bekijken.

In 1 chip worden tot 16 cores aan mekaar gehangen door een 1024 bit brede ringbaan, waarbij één helft linksom gaat en de andere helft rechtsom. Naast de cores worden ook andere zaken op de bus aangesloten, zoals gddr geheugencontrollers, een pci-express interface, een video-encoder,... Versies van meer dan 16 cores zullen meerdere van die ringen gebruiken die mekaar kruisen aan de randen.

Alles kan dus gestuurd worden door de Larrabee. Enkel het filteren van textures zou niet door de core gebeuren omdat dit 12 tot 40 keer trager zou gebeuren. Dit deel wordt dan uitbesteed aan een andere stukje vaste hardware. Dus alle stappen van het renderen zullen op softwareniveau gebeuren.

Ook het woord 'bottleneck' zal in de toekomst verdwijnen, doordat de chip ofwel snel genoeg is ofwel niet. Maar een traag onderdeel dat de rest tegenhoudt zal tot het verleden behoren.

Software-implementatie geeft enorm veel flexibiliteit. Voorbeeld hiervan zou bv. DirectX kunnen zijn. Een grafische processor blijft nu op een bepaalde DirectX versie hangen omdat één van de nieuwe kenmerken van een hogere DirectXversie niet in de hardware ingebakken zit. Door softwarematig te werk te gaan, zou bv. het installeren van een nieuwe driver een upgrade van DirectX kunnen toelaten.

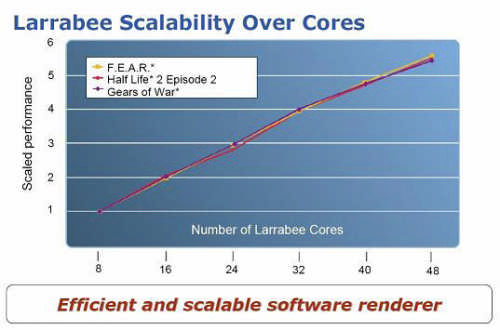

Omdat er nog zo weinig bekend is omtrent de kloksnelheid en het aantal cores, is het moeilijk om over prestaties te spreken. Wel heeft Intel trachten te simuleren in hoeverre het ontwerp schaalbaar is.

Uit deze simulatie bleek dat de chip in ieder geval van 8 tot 48 cores met 90% tot 93% bijna perfect schaalt; d.w.z. dat een versie met 32 cores écht 2x zo snel is als een 16-core versie, toch als ook het aantal texture-eenheden en de geheugenbandbreedte evenredig meegroeien.

Voorbeeld: Gaan we uit van een kloksnelheid van 1GHz, dan heeft Intel berekend dat onderstaande 3 spellen met 25 cores minimum 60 frames per seconde moeten halen. Met andere snelheden en cores kan je de berekening van het aantal frames makkelijk zelf maken...

Vast staat dat het belooft een zéér interessante chip te worden, en dat allemaal zonder af te wijken van de vertrouwde x86 standaard. Het zou een videokaart worden die met 24 cores en, een kloksnelheid van 2GHz en een tdp van 150W een rekenkracht zou hebben van 1,5 teraflops, zo'n 25 tot 50% méér dan de snelste huidige videokaart.

Hoe de chip uiteindelijk in de rekken zal liggen is ook nog niet gekend. Is het als GPU op een high-end videokaart of als losse CPU? Sommigen beweren dat zelfs een mengeling van de 2 mogelik is... bv. 4 CPU's en 16 GPU's op 1 chip... Rond 2010 zullen we het weten...afwachten dus is de boodschap.

Bron: hardware.info, tweakers.net, fudzilla.com

Categorieën

Categorieën